Giải Nobel Vật lý năm nay vinh danh những người đã sử dụng các công cụ từ vật lý để xây dựng các phương pháp đặt nền móng cho học máy mạnh mẽ ngày nay. John Hopfield tạo ra một cấu trúc có thể lưu trữ và tái tạo thông tin. Geoffrey Hinton phát minh ra một phương pháp có thể độc lập khám phá các thuộc tính trong dữ liệu và đã trở nên quan trọng đối với các mạng nơ-ron nhân tạo lớn hiện đang được sử dụng.

Nhiều người đã trải nghiệm cách máy tính có thể dịch giữa các ngôn ngữ, diễn giải hình ảnh và thậm chí tiến hành các cuộc trò chuyện hợp lý. Điều có lẽ ít được biết đến hơn là loại công nghệ này từ lâu đã quan trọng đối với nghiên cứu, bao gồm việc sắp xếp và phân tích lượng lớn dữ liệu. Sự phát triển của học máy đã bùng nổ trong mười lăm đến hai mươi năm qua và sử dụng một cấu trúc gọi là mạng nơ-ron nhân tạo. Ngày nay, khi chúng ta nói về trí tuệ nhân tạo, đây thường là loại công nghệ mà chúng ta muốn nói đến.

Mặc dù máy tính không thể suy nghĩ, nhưng giờ đây máy móc có thể bắt chước các chức năng như trí nhớ và học tập. Những người đoạt giải vật lý năm nay đã giúp biến điều này thành hiện thực. Sử dụng các khái niệm và phương pháp cơ bản từ vật lý, họ đã phát triển các công nghệ sử dụng cấu trúc trong mạng để xử lý thông tin.

Học máy khác với phần mềm truyền thống, hoạt động giống như một loại công thức. Phần mềm nhận dữ liệu, được xử lý theo mô tả rõ ràng và tạo ra kết quả, giống như khi ai đó thu thập các thành phần và xử lý chúng bằng cách làm theo công thức, tạo ra một chiếc bánh. Thay vì điều này, trong học máy, máy tính học bằng ví dụ, cho phép nó giải quyết các vấn đề quá mơ hồ và phức tạp để có thể quản lý bằng hướng dẫn từng bước. Một ví dụ là diễn giải một bức tranh để xác định các đối tượng trong đó.

Bắt chước bộ não

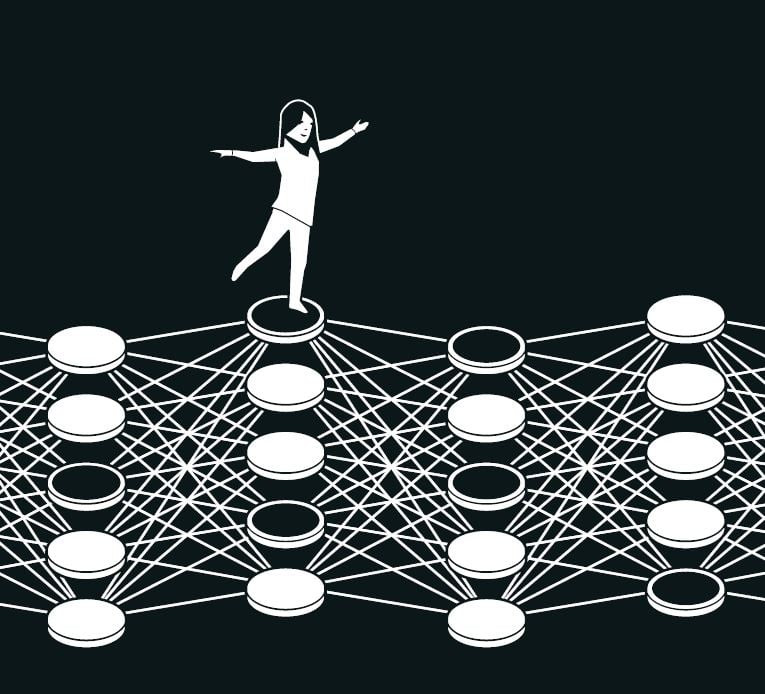

Một mạng nơ-ron nhân tạo xử lý thông tin bằng cách sử dụng toàn bộ cấu trúc mạng. Cảm hứng ban đầu đến từ mong muốn hiểu cách bộ não hoạt động. Vào những năm 1940, các nhà nghiên cứu đã bắt đầu suy luận xung quanh toán học làm nền tảng cho mạng lưới nơ-ron và khớp thần kinh của não. Một mảnh ghép khác đến từ tâm lý học, nhờ giả thuyết của nhà khoa học thần kinh Donald Hebb về cách học tập xảy ra vì các kết nối giữa các nơ-ron được củng cố khi chúng làm việc cùng nhau.

Sau đó, những ý tưởng này được tiếp nối bằng các nỗ lực tái tạo cách mạng lưới của não hoạt động bằng cách xây dựng các mạng nơ-ron nhân tạo dưới dạng mô phỏng máy tính. Trong số này, các nơ-ron của não được bắt chước bởi các nút được gán các giá trị khác nhau và các khớp thần kinh được biểu thị bằng các kết nối giữa các nút có thể được làm mạnh hơn hoặc yếu hơn. Giả thuyết của Donald Hebb vẫn được sử dụng làm một trong những quy tắc cơ bản để cập nhật các mạng nhân tạo thông qua một quá trình gọi là đào tạo.

Vào cuối những năm 1960, một số kết quả lý thuyết đáng thất vọng đã khiến nhiều nhà nghiên cứu nghi ngờ rằng những mạng nơ-ron này sẽ không bao giờ có bất kỳ ứng dụng thực tế nào. Tuy nhiên, sự quan tâm đến mạng nơ-ron nhân tạo đã được khơi dậy trở lại vào những năm 1980, khi một số ý tưởng quan trọng đã gây được tiếng vang, bao gồm cả công trình của những người đoạt giải năm nay.

Bộ nhớ liên kết

Hãy tưởng tượng rằng bạn đang cố gắng nhớ một từ khá khác thường mà bạn hiếm khi sử dụng, chẳng hạn như một từ cho sàn dốc thường thấy trong rạp chiếu phim và giảng đường. Bạn tìm kiếm trong trí nhớ của mình. Nó giống như ramp… có lẽ rad…ial? Không, không phải thế. Rake, đúng rồi!

Quá trình tìm kiếm thông qua các từ tương tự để tìm từ đúng này gợi nhớ đến bộ nhớ liên kết mà nhà vật lý John Hopfield đã phát hiện ra vào năm 1982. Mạng Hopfield có thể lưu trữ các mẫu và có một phương pháp để tái tạo chúng. Khi mạng được cung cấp một mẫu không đầy đủ hoặc hơi méo, phương pháp này có thể tìm thấy mẫu được lưu trữ tương tự nhất.

Hopfield trước đây đã sử dụng nền tảng vật lý của mình để khám phá các vấn đề lý thuyết trong sinh học phân tử. Khi được mời đến một cuộc họp về khoa học thần kinh, ông đã gặp các nghiên cứu về cấu trúc của não. Ông bị mê hoặc bởi những gì mình học được và bắt đầu suy nghĩ về động lực học của các mạng nơ-ron đơn giản. Khi các nơ-ron hoạt động cùng nhau, chúng có thể tạo ra những đặc điểm mới và mạnh mẽ mà người chỉ nhìn vào các thành phần riêng biệt của mạng không thể thấy rõ.

Năm 1980, Hopfield rời vị trí của mình tại Đại học Princeton, nơi các mối quan tâm nghiên cứu của ông đã đưa ông ra ngoài các lĩnh vực mà các đồng nghiệp vật lý của ông đang làm việc và chuyển qua lục địa. Ông đã chấp nhận lời đề nghị làm giáo sư hóa học và sinh học tại Caltech (Viện Công nghệ California) ở Pasadena, miền nam California. Ở đó, ông có quyền truy cập vào các tài nguyên máy tính mà ông có thể sử dụng để thử nghiệm miễn phí và phát triển các ý tưởng của mình về mạng nơ-ron.

Tuy nhiên, ông không từ bỏ nền tảng của mình trong vật lý, nơi ông tìm thấy cảm hứng cho sự hiểu biết của mình về cách các hệ thống với nhiều thành phần nhỏ hoạt động cùng nhau có thể tạo ra những hiện tượng mới và thú vị. Ông đặc biệt được hưởng lợi từ việc tìm hiểu về các vật liệu từ tính có các đặc tính đặc biệt nhờ spin nguyên tử của chúng – một thuộc tính khiến mỗi nguyên tử trở thành một nam châm nhỏ. Các spin của các nguyên tử lân cận ảnh hưởng lẫn nhau; điều này có thể cho phép các miền hình thành với spin theo cùng một hướng. Ông đã có thể tạo ra một mạng mô hình với các nút và kết nối bằng cách sử dụng vật lý mô tả cách các vật liệu phát triển khi các spin ảnh hưởng lẫn nhau.

Mạng lưu hình ảnh trong một không gian

Mạng mà Hopfield xây dựng có các nút được kết nối với nhau thông qua các kết nối có độ mạnh khác nhau. Mỗi nút có thể lưu trữ một giá trị riêng lẻ – trong công trình đầu tiên của Hopfield, giá trị này có thể là 0 hoặc 1, giống như các pixel trong ảnh đen trắng.

Hopfield mô tả trạng thái tổng thể của mạng với một thuộc tính tương đương với năng lượng trong hệ thống spin được tìm thấy trong vật lý; năng lượng được tính bằng công thức sử dụng tất cả các giá trị của các nút và tất cả các cường độ của các kết nối giữa chúng. Mạng Hopfield được lập trình bằng cách đưa một hình ảnh vào các nút, được gán giá trị đen (0) hoặc trắng (1). Sau đó, các kết nối của mạng được điều chỉnh bằng công thức năng lượng, để hình ảnh đã lưu có năng lượng thấp. Khi một mẫu khác được đưa vào mạng, có một quy tắc để đi qua các nút từng nút một và kiểm tra xem mạng có năng lượng thấp hơn hay không nếu giá trị của nút đó bị thay đổi. Nếu hóa ra năng lượng giảm nếu một pixel đen thay vào đó là màu trắng, nó sẽ thay đổi màu sắc. Thủ tục này tiếp tục cho đến khi không thể tìm thấy bất kỳ cải tiến nào nữa. Khi đạt đến điểm này, mạng thường đã tái tạo hình ảnh gốc mà nó được đào tạo.

Điều này có vẻ không quá đáng chú ý nếu bạn chỉ lưu một mẫu. Có lẽ bạn đang tự hỏi tại sao bạn không chỉ lưu chính hình ảnh đó và so sánh nó với một hình ảnh khác đang được kiểm tra, nhưng phương pháp của Hopfield là đặc biệt vì một số hình ảnh có thể được lưu cùng một lúc và mạng thường có thể phân biệt giữa chúng.

Hopfield so sánh việc tìm kiếm mạng cho một trạng thái đã lưu với việc lăn một quả bóng qua một cảnh quan gồm các đỉnh và thung lũng, với ma sát làm chậm chuyển động của nó. Nếu quả bóng rơi vào một vị trí cụ thể, nó sẽ lăn vào thung lũng gần nhất và dừng lại ở đó. Nếu mạng được cung cấp một mẫu gần với một trong các mẫu đã lưu, nó sẽ theo cách tương tự, tiếp tục di chuyển về phía trước cho đến khi nó kết thúc ở đáy thung lũng trong cảnh quan năng lượng, do đó tìm thấy mẫu gần nhất trong bộ nhớ của nó.

Mạng Hopfield có thể được sử dụng để tái tạo dữ liệu có chứa nhiễu hoặc đã bị xóa một phần.

Hopfield và những người khác đã tiếp tục phát triển các chi tiết về cách mạng Hopfield hoạt động, bao gồm cả các nút có thể lưu trữ bất kỳ giá trị nào, không chỉ số không hoặc một. Nếu bạn nghĩ về các nút như các pixel trong một bức tranh, chúng có thể có các màu khác nhau, không chỉ đen hoặc trắng. Các phương pháp cải tiến đã giúp có thể lưu nhiều hình ảnh hơn và phân biệt giữa chúng ngay cả khi chúng khá giống nhau. Có thể xác định hoặc tái tạo bất kỳ thông tin nào, miễn là nó được xây dựng từ nhiều điểm dữ liệu.

Phân loại bằng vật lý thế kỷ XIX

Ghi nhớ một hình ảnh là một chuyện, nhưng giải thích những gì nó mô tả đòi hỏi nhiều hơn một chút.

Ngay cả những đứa trẻ rất nhỏ cũng có thể chỉ vào các con vật khác nhau và tự tin nói đó là chó, mèo hay sóc. Đôi khi chúng có thể nhầm lẫn, nhưng khá sớm chúng đã đúng gần như mọi lúc. Một đứa trẻ có thể học được điều này ngay cả khi không nhìn thấy bất kỳ sơ đồ hoặc giải thích nào về các khái niệm như loài hoặc động vật có vú. Mọi người học cách nhận ra một con mèo, hoặc hiểu một từ, hoặc bước vào một căn phòng và nhận thấy rằng có điều gì đó đã thay đổi, bằng cách trải nghiệm môi trường xung quanh chúng.

Khi Hopfield xuất bản bài báo của mình về bộ nhớ liên kết, Geoffrey Hinton đang làm việc tại Đại học Carnegie Mellon ở Pittsburgh, Hoa Kỳ. Trước đây ông đã nghiên cứu tâm lý học thực nghiệm và trí tuệ nhân tạo ở Anh và Scotland và đang tự hỏi liệu máy móc có thể học cách xử lý các mẫu theo cách tương tự như con người, tìm ra các danh mục riêng của chúng để sắp xếp và giải thích thông tin hay không. Cùng với đồng nghiệp của mình, Terrence Sejnowski, Hinton bắt đầu từ mạng Hopfield và mở rộng nó để xây dựng một thứ gì đó mới, sử dụng các ý tưởng từ vật lý thống kê.

Vật lý thống kê mô tả các hệ thống bao gồm nhiều phần tử tương tự, chẳng hạn như các phân tử trong một chất khí. Rất khó hoặc không thể theo dõi tất cả các phân tử riêng biệt trong chất khí, nhưng có thể xem xét chúng một cách tập thể để xác định các thuộc tính bao trùm của chất khí như áp suất hoặc nhiệt độ. Có nhiều cách tiềm năng để các phân tử khí lan truyền qua thể tích của nó ở tốc độ riêng lẻ và vẫn tạo ra các thuộc tính tập thể tương tự.

Các trạng thái mà các thành phần riêng lẻ có thể cùng tồn tại có thể được phân tích bằng vật lý thống kê và xác suất xảy ra của chúng được tính toán. Một số trạng thái có khả năng xảy ra cao hơn những trạng thái khác; điều này phụ thuộc vào lượng năng lượng có sẵn, được mô tả trong một phương trình bởi nhà vật lý thế kỷ XIX Ludwig Boltzmann. Mạng của Hinton đã sử dụng phương trình đó và phương pháp này đã được xuất bản vào năm 1985 dưới cái tên nổi bật là máy Boltzmann.

Nhận ra các ví dụ mới về cùng một loại

Máy Boltzmann thường được sử dụng với hai loại nút khác nhau. Thông tin được đưa đến một nhóm, được gọi là các nút hiển thị. Các nút còn lại tạo thành một lớp ẩn. Các giá trị và kết nối của các nút ẩn cũng đóng góp vào năng lượng của toàn bộ mạng.

Máy được vận hành bằng cách áp dụng một quy tắc để cập nhật các giá trị của các nút từng nút một. Cuối cùng, máy sẽ vào một trạng thái trong đó mẫu của các nút có thể thay đổi, nhưng các thuộc tính của mạng nói chung vẫn giữ nguyên. Mỗi mẫu có thể có sẽ có một xác suất cụ thể được xác định bởi năng lượng của mạng theo phương trình Boltzmann. Khi máy dừng, nó đã tạo ra một mẫu mới, điều này làm cho máy Boltzmann trở thành một ví dụ ban đầu về mô hình tạo.

Máy Boltzmann có thể học – không phải từ hướng dẫn, mà từ việc được cung cấp các ví dụ. Nó được đào tạo bằng cách cập nhật các giá trị trong các kết nối của mạng để các mẫu ví dụ, được đưa đến các nút hiển thị khi nó được đào tạo, có xác suất xảy ra cao nhất có thể khi máy đang chạy. Nếu cùng một mẫu được lặp lại nhiều lần trong quá trình đào tạo này, thì xác suất cho mẫu này thậm chí còn cao hơn. Đào tạo cũng ảnh hưởng đến xác suất xuất ra các mẫu mới giống với các ví dụ mà máy được đào tạo.

Một máy Boltzmann đã qua đào tạo có thể nhận ra các đặc điểm quen thuộc trong thông tin mà nó chưa từng thấy trước đây. Hãy tưởng tượng gặp anh chị em của một người bạn và bạn có thể ngay lập tức thấy rằng họ phải có quan hệ họ hàng. Tương tự, máy Boltzmann có thể nhận ra một ví dụ hoàn toàn mới nếu nó thuộc một danh mục được tìm thấy trong tài liệu đào tạo và phân biệt nó với tài liệu không giống nhau.

Trong hình thức ban đầu của nó, máy Boltzmann khá kém hiệu quả và mất nhiều thời gian để tìm ra giải pháp. Mọi thứ trở nên thú vị hơn khi nó được phát triển theo nhiều cách khác nhau, điều mà Hinton đã tiếp tục khám phá. Các phiên bản sau này đã được làm mỏng hơn, vì các kết nối giữa một số đơn vị đã bị loại bỏ. Hóa ra điều này có thể làm cho máy hiệu quả hơn.

Trong những năm 1990, nhiều nhà nghiên cứu đã mất hứng thú với mạng nơ-ron nhân tạo, nhưng Hinton là một trong những người tiếp tục làm việc trong lĩnh vực này. Ông cũng giúp bắt đầu một vụ nổ mới về các kết quả thú vị; vào năm 2006, ông và các đồng nghiệp Simon Osindero, Yee Whye Teh và Ruslan Salakhutdinov đã phát triển một phương pháp để huấn luyện trước một mạng với một loạt máy Boltzmann theo lớp, lớp này trên lớp kia. Việc huấn luyện trước này đã cho các kết nối trong mạng một điểm khởi đầu tốt hơn, điều này tối ưu hóa quá trình đào tạo của nó để nhận ra các yếu tố trong hình ảnh.

Máy Boltzmann thường được sử dụng như một phần của mạng lớn hơn. Ví dụ, nó có thể được sử dụng để đề xuất phim hoặc chương trình truyền hình dựa trên sở thích của người xem.

Học máy – hôm nay và ngày mai

Nhờ công việc của họ từ những năm 1980 trở đi, John Hopfield và Geoffrey Hinton đã giúp đặt nền móng cho cuộc cách mạng học máy bắt đầu vào khoảng năm 2010.

Sự phát triển mà chúng ta đang chứng kiến hiện nay đã được thực hiện có thể thông qua quyền truy cập vào lượng lớn dữ liệu có thể được sử dụng để đào tạo mạng và thông qua sự gia tăng lớn về sức mạnh tính toán. Mạng nơ-ron nhân tạo ngày nay thường rất lớn và được xây dựng từ nhiều lớp. Chúng được gọi là mạng nơ-ron sâu và cách chúng được đào tạo được gọi là học sâu.

Một cái nhìn nhanh chóng vào bài báo của Hopfield về bộ nhớ liên kết, từ năm 1982, cung cấp một số quan điểm về sự phát triển này. Trong đó, ông đã sử dụng một mạng với 30 nút. Nếu tất cả các nút được kết nối với nhau, có 435 kết nối. Các nút có giá trị của chúng, các kết nối có độ mạnh khác nhau và, tổng cộng, có ít hơn 500 tham số cần theo dõi. Ông cũng đã thử một mạng với 100 nút, nhưng điều này quá phức tạp, với máy tính mà ông đang sử dụng vào thời điểm đó. Chúng ta có thể so sánh điều này với các mô hình ngôn ngữ lớn ngày nay, được xây dựng dưới dạng các mạng có thể chứa hơn một nghìn tỷ tham số (một triệu triệu).

Nhiều nhà nghiên cứu hiện đang phát triển các lĩnh vực ứng dụng của học máy. Cái nào sẽ khả thi nhất vẫn còn phải xem, trong khi cũng có một cuộc thảo luận rộng rãi về các vấn đề đạo đức xung quanh sự phát triển và sử dụng công nghệ này.

Bởi vì vật lý đã đóng góp các công cụ cho sự phát triển của học máy, nên thật thú vị khi thấy vật lý, với tư cách là một lĩnh vực nghiên cứu, cũng được hưởng lợi từ mạng nơ-ron nhân tạo như thế nào. Học máy từ lâu đã được sử dụng trong các lĩnh vực mà chúng ta có thể quen thuộc từ các Giải Nobel Vật lý trước đây. Chúng bao gồm việc sử dụng học máy để sàng lọc và xử lý lượng lớn dữ liệu cần thiết để khám phá hạt Higgs. Các ứng dụng khác bao gồm giảm nhiễu trong các phép đo sóng hấp dẫn từ các lỗ đen va chạm, hoặc tìm kiếm các hành tinh ngoài hệ mặt trời.

Trong những năm gần đây, công nghệ này cũng bắt đầu được sử dụng khi tính toán và dự đoán các thuộc tính của các phân tử và vật liệu – chẳng hạn như tính toán cấu trúc phân tử protein, xác định chức năng của chúng hoặc tìm ra phiên bản mới nào của vật liệu có thể có các thuộc tính tốt nhất để sử dụng trong các tế bào mặt trời hiệu quả hơn.